深度学习与人工智能(AI)目前是计算机研究领域的热点,借助计算机深度学习的强大能力,视觉数据集目前在计算机图像学及视觉领域备受关注。9月3月,在英国纽卡斯尔大学召开的计算机视觉大会BMVC(BRITISH MACHINE VISION CONFERENCE)上,酷家乐联手英国帝国理工大学计算机机器人视觉实验室及美国南加州大学,推出全球最大的SLAM(Simultaneous Localization and Mapping,同步定位与地图构建)深度学习数据集。

酷家乐携手推出全球最大室内场景认知深度学习数据集

BMVC计算机视觉大会是计算机视觉和相关领域几大重要国际性会议之一,自1985年以来已成功举办28届。今年会议共收到862篇有效论文,有258篇论文被接收(接收率为29.9%)。

这当中包括由酷家乐、英国帝国理工大学、美国南加州大学联合完成的论文《InteriorNet: Mega-scale Multi-sensor Photo-realistic Indoor Scenes Dataset》。与此同时,酷家乐与帝国理工大学、美国南加州大学联手推出InteriorNet数据集。这是目前世界上最大的公开室内场景认知数据集。

近年来,以Google ImageNet、Microsoft COCO和Intel GTA5为代表的认知类数据集为场景认知、物体识别等深度学习相关的AI认知系统提供了巨大的驱动力。比如Intel GTA5就被应用到自动驾驶汽车项目,用来训练无人驾驶AI,以成为业界标杆。

酷家乐是行业领先的家居云设计平台,一直专注于将AI这样的新技术注入家居行业,不断研发AI技术,同时平台积累的大量逼近于真实场景的室内设计数据也将反哺人工智能技术的发展。因此,酷家乐联合学术界推出广泛用于室内场景认知的数据集,不仅推动行业升级,优化家居智能体验,同时也推动人类科技的前进。

InteriorNet数据集助力室内场景AI革命

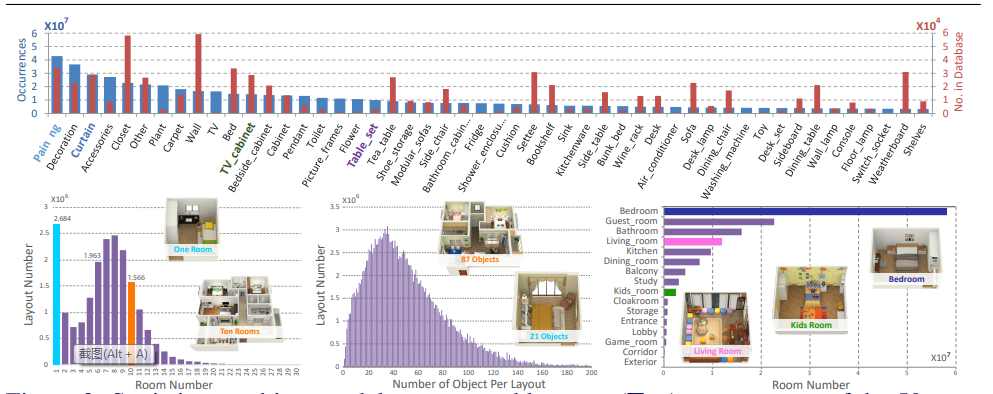

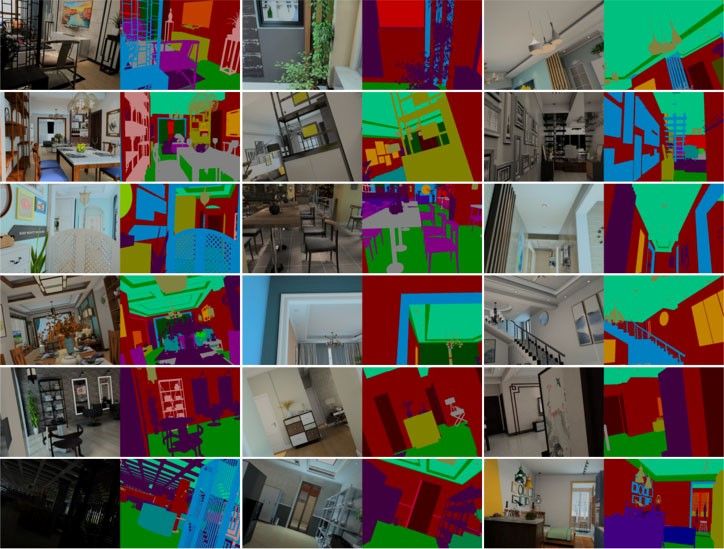

InteriorNet深度学习数据集中包含了1600万组像素级标签数据,包含1.5万组视频数据,共计约1亿3千万图像数据。该数据集对无人机/智能机器人在室内场景的运动状态及观察数据进行模拟。

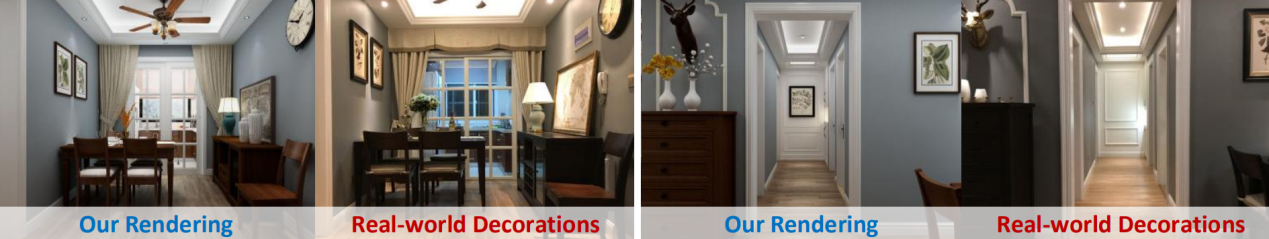

其中,英国帝国理工大学Wenbin Li博士主持研发的Visim工具负责在指定场景中自动\手动生成无人机观察及行进轨迹;随后机器人观察到的图像数据则均通过酷家乐自主研发的AI光线追踪渲染引擎 (Kujiale FF AI Render Engine)对无人机在设计师设计的室内场景中进行渲染产生。

通过深度学习和场景识别,系统可以自动快速的生成大量的样板间,从而不需要真实拍摄即可获得室内场景的大量数据集,形成最接近于现实情况的数据集,用于室内场景的更多AI探索中。

InteriorNet数据集类似于英特尔针推无人驾驶推出的GTA5深度学习数据集,它基于虚拟场景,通过光线追踪渲染引擎产生的图像,其标记数据精准度可达到像素级分割。在输出RGB及标注信息的同时,InteriorNet还提供了多种像素级精度的辅助数据,如深度信息、法相信息、光照信息等。更为突出的是,InteriorNet同时提供了3种相机模型(标准透视相机,鱼眼相机和全景相机)。

众所周知,对于AI技术的研究,首先要有大量的数据积累。酷家乐联手英国帝国理工大学、美国南加州大学共同推出的InteriorNet数据集通过智能化、高效率、低成本的方式,生成庞大而真实的数据,既为未来AI技术在室内场景的探索提供数据基础,同时也不断成熟的数据架构也在反哺AI应用的成熟。酷家乐会时刻紧跟图形图像领域的最先进研究方向,将最新技术融入到大家居行业中,推动行业的变革。

关注我们

酷家乐质量效能团队热衷于技术的成长和分享,几乎每个月都会举办技术分享活动(海星日),每半年举办一次技术专题竞赛分享(火星日),并将优秀内容写成技术文章。

我们尽可能保障分享到社区的内容,是我们用心编写、精心挑选的优质文章。如果您想更全面地阅读我们的文章,请您关注我们的微信公众号"酷家乐技术质量"。